Forschungsdatenmanagement - Eine Online-Einführung

Résumé de section

-

Herausgeber: HeFDI - Hessische Forschungsdateninfrastrukturen

Kontakt: forschungsdaten@fit.fra-uas.de

Bearbeitungsdauer gesamt (ohne Videos): ca. 2,5 Stunden

Zuletzt geändert: März 2022 -

Herausgeber: HeFDI - Hessische Forschungsdateninfrastrukturen

Autor*innen (in alphabetischer Reihenfolge): Esther Krähwinkel (Philipps-Universität Marburg), Patrick Langner (Hochschule Fulda), Robert Lipp (Frankfurt University of Applied Sciences), Andre Pietsch (Justus-Liebig-Universität Gießen)

Review: Wir danken Stefanie Blum und Marion Elzner, Hochschule Geisenheim, für Ihren Input sowie den Kolleginnen und Kollegen des Thüringer Kompetenznetzwerks Forschungsdatenmanagement, der AG Prof. Goesmann, Bioinformatik und Systembiologie, Universität Gießen und Dr. Reinhard Gerhold, Universität Kassel, für ihr wertvolles Feedback.

Voraussetzungen: Für dieses Lernmodul sind keine Vorkenntnisse erforderlich. Die Kapitel sind thematisch aufeinander aufbauend, können aber auch einzeln bearbeitet werden.

Zielgruppe: Studierende, Promovierende und Forschende, die einen ersten Einstieg in das Forschungsdatenmanagement suchen.

Bearbeitungsdauer (mit Videos): 3 Stunden, 15 Minuten

Bearbeitungsdauer (ohne Videos): 2 Stunden, 10 MinutenLernziel: Nach Abschluss dieser Selbstlerneinheit können Sie die Inhalte und den Sinn von Forschungsdatenmanagement verstehen und umsetzen. Die Lernziele im Einzelnen sind den jeweiligen Kapiteln vorangestellt.

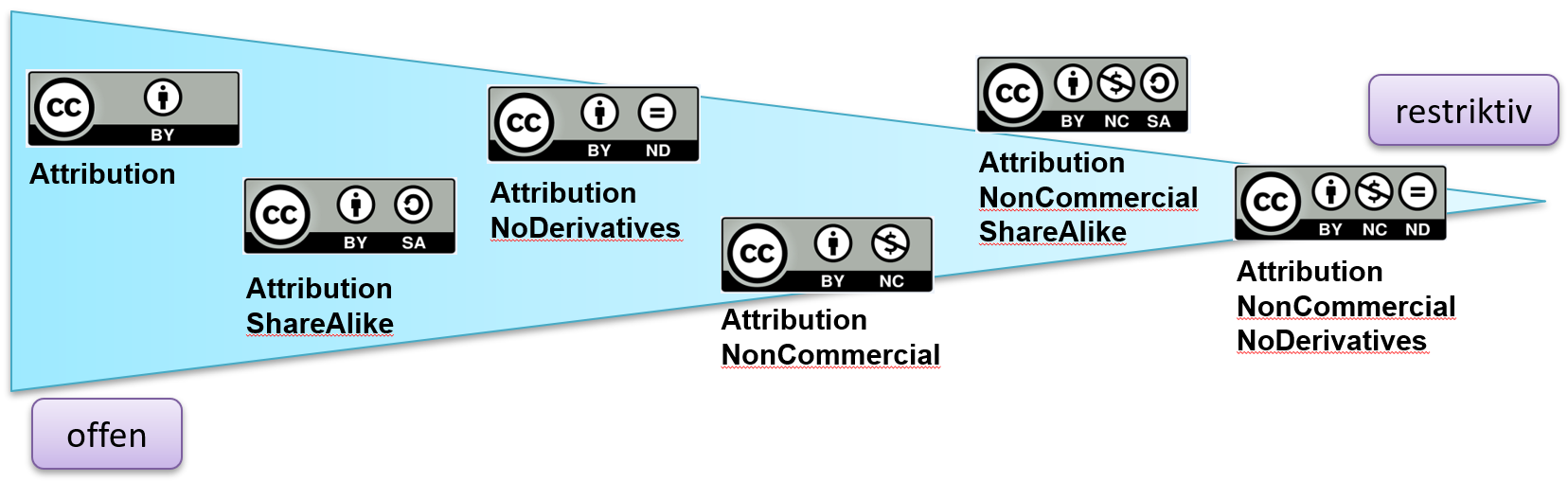

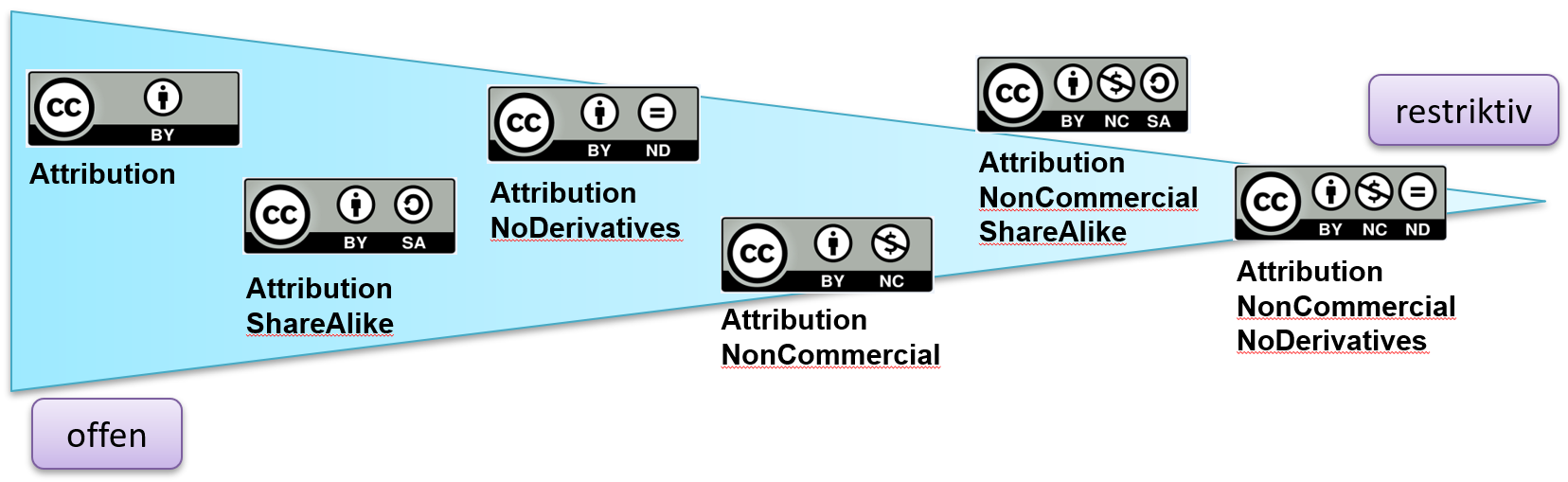

Lizensierung: Dieses Modul ist lizensiert unter Creative Commons Attribution-ShareAlike 4.0 International (CC BY-SA 4.0) und öffentlich verfügbar unter https://doi.org/10.5281/zenodo.6373595.

Datenschutz - eingebettete Videos: In diesem Lernmodul sind auf den Folgeseiten Videos von YouTube eingebettet. Beim Aufruf werden durch Google/YouTube Cookies und andere Daten verwendet, verarbeitet und ggf. weitergegeben. Informationen zu Datenschutz und Nutzungsbedingungen des Dienstes finden Sie hier. Die Nutzung des Lernmoduls setzt ein entsprechendes Einverständnis voraus.

-

- Forschungsdaten.info - Informationsportal zum Forschungsdatenmanagement im deutschsprachigen Raum

- Forschungsdaten leben länger...

- Anschauliche Lehrvideos der RWTH Aachen (Deutsch/Englisch)

- Lokale FDM-Servicestelle

der Frankfurt UAS - Hier finden Sie Ihre lokalen Ansprechpersonen,

Informationen zum Beratungs- und Schulungsangebot sowie weitere Services

- Hessische Forschungsdateninfrastrukturen (HeFDI) - Hessische Landesinitiative zur Förderung von Forschungsdatenmanagement; unter anderem durch Schulungen und Workshops

- Nationale Forschungsdateninfrastruktur (NFDI) - Bundesweite Initiative zur Erschließung und Nachnutzbarmachung wissenschaftlicher Datenbestände

- Rat für Informationsinfrastrukturen (RfII)

- Von der Gemeinsamen Wissenschaftskonferenz (GWK) berufenes

Expertengremium, das regelmäßig Berichte, Empfehlungen und

Positionspapiere veröffentlicht. Empfehlenswert ist insbesondere der

wöchentliche Mail-Service mit aktuellen Infos rund um das Thema Forschungsdatenmanagement

- Research Data Allicance Deutschland (RDA DE) - Deutschsprachiger Ableger der internationalen Community von Daten-Expert*innen

- European Open Science Cloud (EOSC) - Metaportal der Europäischen Union zur Bündelung von Services zur Verfügbarmachung von Forschungsdaten

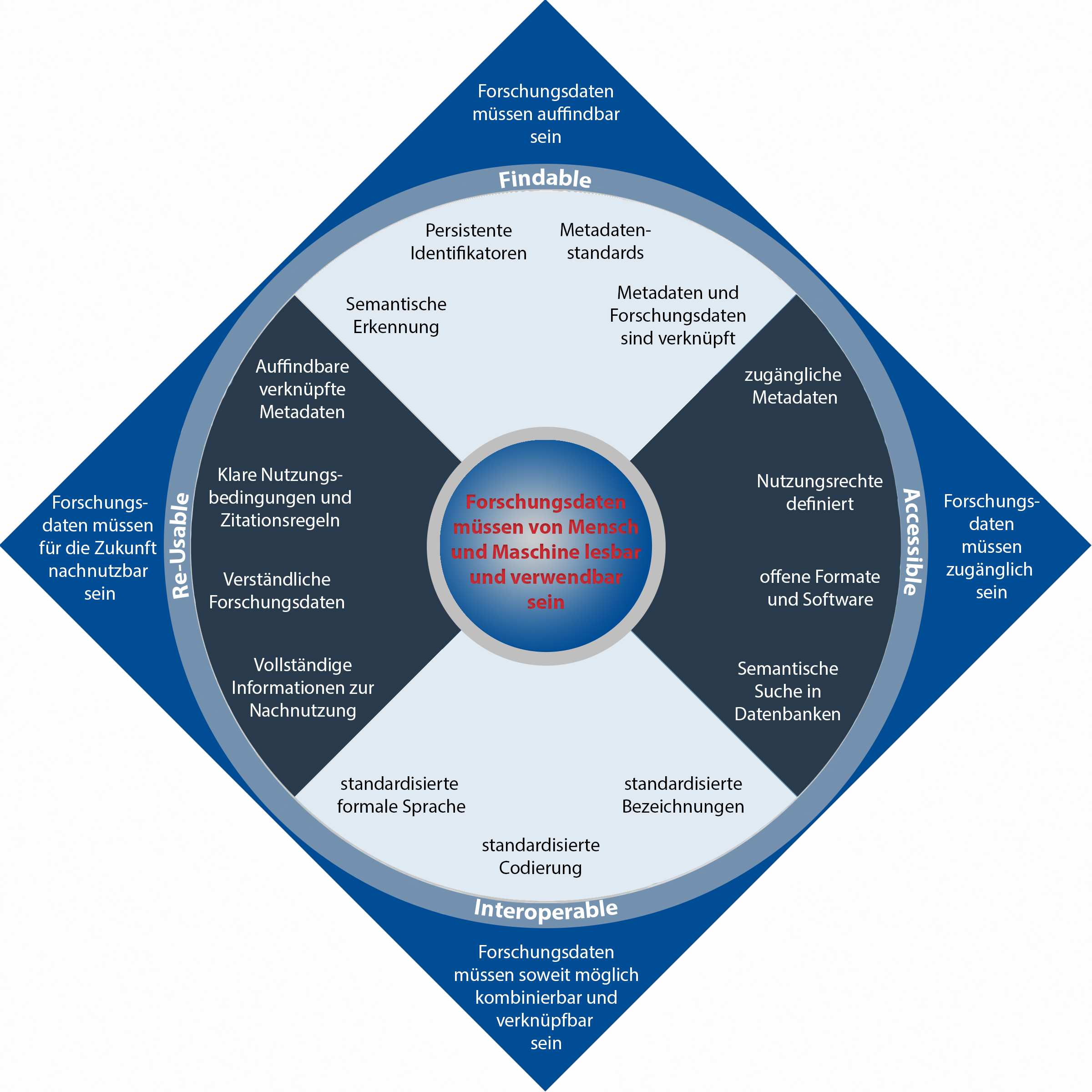

- GO FAIR Initiative - Zentrales, europäisches Informationsportal zur Umsetzung der FAIR-Prinzipien (findable, accessible, interoperable, reusable)

- Forschungsdaten.info - Informationsportal zum Forschungsdatenmanagement im deutschsprachigen Raum

-

Quelle: Becker, Henrike, Einwächter, Sophie, Klein, Benedikt, Krähwinkel, Esther, Mehl, Sebastian, Müller, Janine, Werthmüller, Julia. (2019). Lernmodul Forschungsdatenmanagement auf einen Blick – eine Online-Einführung. Zenodo. https://doi.org/10.5281/zenodo.3381956

-

Bearbeitungsdauer: 15 Minuten, 36 Sekunden

-

Testen Sie Ihr Wissen über die Inhalte dieses Kapitels!

-

Hier sind noch einmal die wichtigsten Fakten zum Kapitel zusammengefasst.

-

Bearbeitungsdauer: 9 Minuten, 45 Sekunden

-

Testen Sie Ihr Wissen über die Inhalte dieses Kapitels!

-

Hier sind noch einmal die wichtigsten Fakten zum Kapitel zusammengefasst.

-

Bearbeitungsdauer: 11 Minuten, 12 Sekunde

Bearbeitungsdauer (ohne Video): 5 Minuten, 53 Sekunden-

Testen Sie Ihr Wissen über die Inhalte dieses Kapitels!

-

Hier sind noch einmal die wichtigsten Fakten zum Kapitel zusammengefasst.

-

Bearbeitungsdauer: 24 Minuten, 12 Sekunden

-

Testen Sie Ihr Wissen über die Inhalte dieses Kapitels!

-

Hier sind noch einmal die wichtigsten Fakten zum Kapitel zusammengefasst.

-

Bearbeitungsdauer: 14 Minuten, 4 Sekunden

-

Testen Sie Ihr Wissen über die Inhalte dieses Kapitels!

-

Hier sind noch einmal die wichtigsten Fakten zum Kapitel zusammengefasst.

-

Bearbeitungsdauer: 13 Minuten, 47 Sekunden

Bearbeitungsdauer (ohne Video): 10 Minuten, 35 Sekunden-

Testen Sie Ihr Wissen über die Inhalte dieses Kapitels!

-

Hier sind noch einmal die wichtigsten Fakten zum Kapitel zusammengefasst.

-

Bearbeitungsdauer: 21 Minuten, 46 Sekunden

Bearbeitungsdauer (ohne Video): 11 Minuten, 53 Sekunden-

Testen Sie Ihr Wissen über die Inhalte dieses Kapitels!

-

Hier sind noch einmal die wichtigsten Fakten zum Kapitel zusammengefasst.

-

Bearbeitungsdauer: 18 Minuten, 3 Sekunden

-

Testen Sie Ihr Wissen über die Inhalte dieses Kapitels!

-

Hier sind noch einmal die wichtigsten Fakten zum Kapitel zusammengefasst.

-

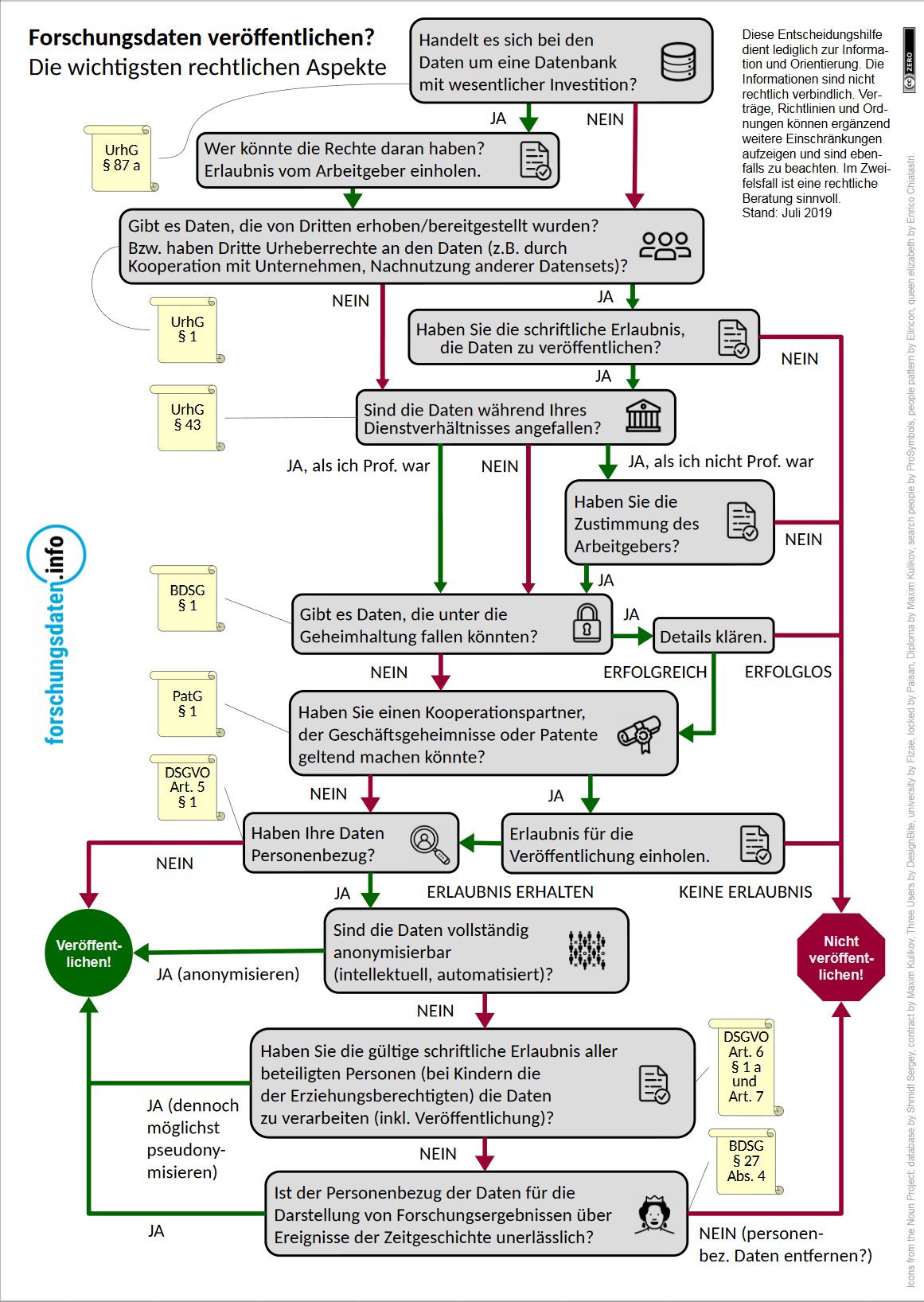

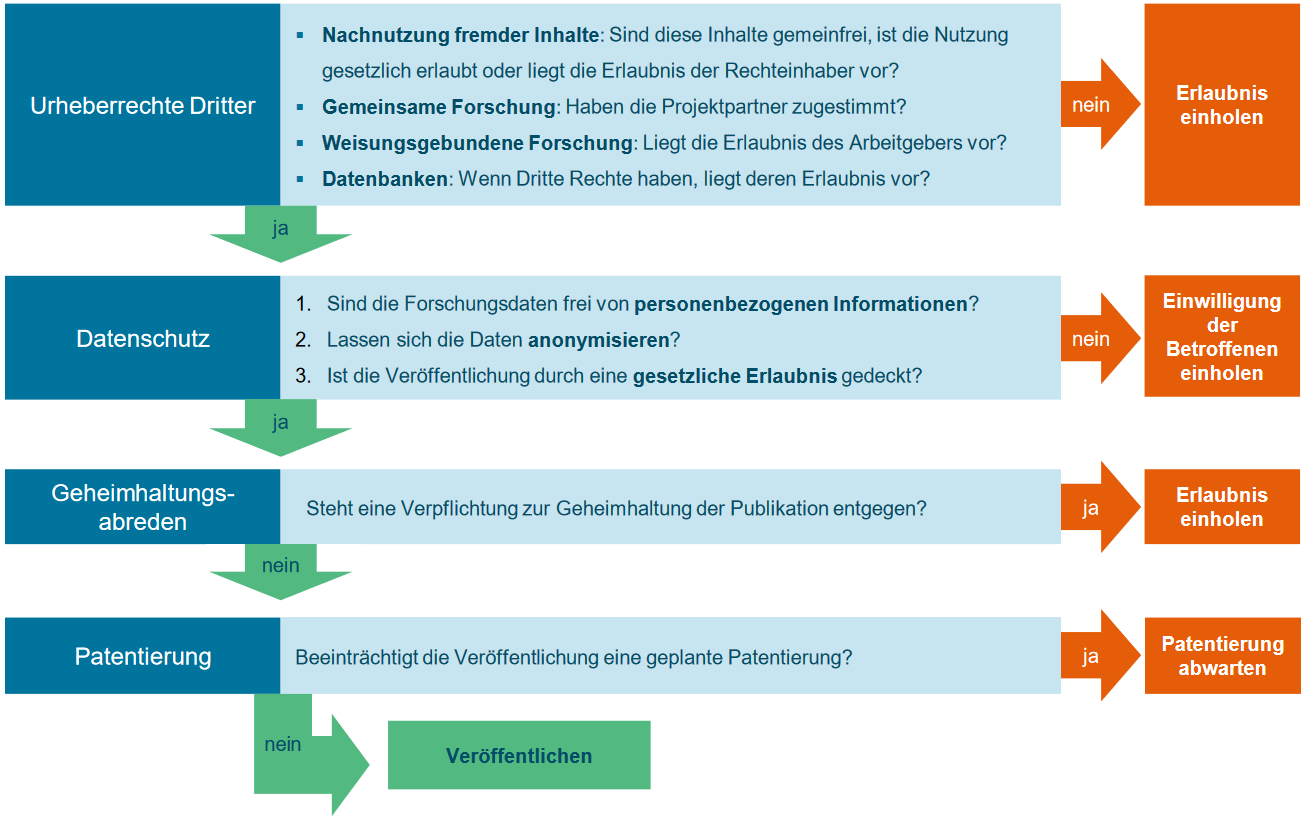

Disclaimer: Keine rechtverbindlichen Informationen! Für eine dezidierte Rechtsberatung zu Ihrer Forschung, wenden Sie sich bitte an das Justiziariat oder den Datenschutzbeauftragten der Frankfurt UAS.

Bearbeitungsdauer: 67 Minuten, 10 Sekunden

Bearbeitungsdauer (ohne Video): 20 Minuten, 36 Sekunden-

Testen Sie Ihr Wissen über die Inhalte dieses Kapitels!

-

Hier sind noch einmal die wichtigsten Fakten zum Kapitel zusammengefasst.